A Revolução da Inteligencia Artificial

Re: A Revolução da Inteligencia Artificial

DeepSeek adia lançamento do novo modelo de IA. A causa? Os chips da Huawei - Tecnologias - Jornal de Negócios

A empresa chinesa de inteligência artificial teve dificuldades técnicas em treinar os chips Ascend e vai perdendo terreno para os rivais, como o ChatGPT, da OpenAI. Dependência da Nvidia aumenta.

A tentativa de diminuir a dependência da tecnologia norte-americana não está a correr como planeado para a China. A DeepSeek adiou o lançamento do seu novo modelo de sistema R2, isto depois de ter trocado os "chips" da Nvidia pelos da Huawei - com o modelo "Ascend" - e ter tido dificuldades em treinar os semicondutores nacionais.

Assim como outras empresas ligadas à inteligência artificial (IA), a DeepSeek foi "encorajada" pelas autoridades de Pequim a utilizar os semicondutores da Huawei em detrimento dos equipamentos da Nvidia depois de ter lançado o modelo R1, em janeiro deste ano.

(...)

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Detesto isto, mas aparentemente é o que a malta quer:

"No rise" não é grande ajuda, mesmo que seja verdade. Já era (demasiado) alta...

OpenAI no x/twitter Escreveu:

We’re making GPT-5 warmer and friendlier based on feedback that it felt too formal before. Changes are subtle, but ChatGPT should feel more approachable now.

You'll notice small, genuine touches like “Good question” or “Great start,” not flattery. Internal tests show no rise in sycophancy compared to the previous GPT-5 personality.

Changes may take up to a day to roll out, more updates soon.

"No rise" não é grande ajuda, mesmo que seja verdade. Já era (demasiado) alta...

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Tendo em conta o alegado atrás sobre onde as bluechips estão (ou não) presentes, aqui fica um resumo breve.

As gigantes da IA (em termos de capitalização de mercado) incluem:

A lista não é exaustiva, mas destaca as maiores em termos de capitalização bolsista. A descrição também é breve mas resumo de forma sintética o foco ou focos principais de cada uma. Nem todas actuam exactamente na mesma área dado que o potencial e a aplicação da IA é já muito abrangente.

Outras que não estão aqui (dado o critério anterior). Podem vir a cotar publicamente em bolsa:

As gigantes da IA (em termos de capitalização de mercado) incluem:

- Nvidia - hardware (GPUs) e software (CUDA, TensorRT, etc)

- Microsoft - software/cloud, largamente em parceria com a OpenAI

- Apple - hardware e software, aposta na integração de serviços

- Google - hardware (TPUs), software, cloud / integração de serviços

- Amazon - hardware próprio, serviços, aposta mais em b2b

- Meta - software (modelos open, etc), aposta em ar/vr

- Tesla - hardware, software, condução autónoma e robótica (Elon Musk tb é CEO da xAI, ver abaixo)

A lista não é exaustiva, mas destaca as maiores em termos de capitalização bolsista. A descrição também é breve mas resumo de forma sintética o foco ou focos principais de cada uma. Nem todas actuam exactamente na mesma área dado que o potencial e a aplicação da IA é já muito abrangente.

Outras que não estão aqui (dado o critério anterior). Podem vir a cotar publicamente em bolsa:

- OpenAI - modelos llm e visão computacional, serviços via api

- xAI - modelos llm e visão computacional

- Anthropic - modelos llm

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

NirSup Escreveu:

Adenda: o mercado, esse tirano absoluto e implacável, está a dar razão à META. Compare-se a sua evolução em Bolsa, desde 2023, com as Outras cotadas, que investem em Inteligência Artificial.

Porque é que escolhes o período de 2023 em diante?

Será porque a Meta tinha acabado de fazer uma enorme correcção?

A corrida da IA começou bem antes de 2023...

Por exemplo, se pegarmos como referência Dezembro de 2017 - quando a Google publicou o paper "Attention is all you need" - então a Google valorizou cerca de 4x (dos 50 para os 200), a Meta valorizou cerca de 4x (dos 180 para os 780). E, não, a corrida também não começou em 2017, começou antes disso. À data de hoje, a capitalização bolsista da Google é maior do que a da Meta. E existem mais empresas com aposta forte na IA com capitalizações ainda mais elevadas (eg, Microsoft).

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Está um bom resumo. Basicamente é isso. Há (o que creio ser uma minoria, mas não estou certo) que acredita que continuando a escalar e acrescentando modulos, se chega lá. Outros entendem que é necessário mudar o paradigma (não basta acrescentar visão e etc, pois continua a faltar algo fundamental, no core continua a estar um NLP model e isso não deverá bastar para o que o modelo tenha, por exemplo, um modelo interno do mundo). De uma forma geral, os modelos neuro-simbólicos são considerados o próximo passo (embora, nunca se sabe, talvez surja outra coisa qualquer). Estas coisas já foram discutidas atrás no tópico, já agora (há bastantes meses atrás)...

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Ainda do Copilot

Estou preguiça para fazer print screens, quem quiser pode imaginar uma tabela.

Estou preguiça para fazer print screens, quem quiser pode imaginar uma tabela.

Great follow-up! Let's unpack whether LLMs can derive or evolve into AGI.

Can LLMs Derive into AGI?

Short answer: Not on their own — but they can be a foundational component in a broader AGI system.

What the Experts Say

LLMs are powerful pattern recognizers, trained on massive text corpora. They excel at language tasks but lack real-world grounding, memory, and autonomous learning.

Some researchers argue that LLMs could evolve toward AGI if integrated with other systems — like vision, memory, and decision-making modules.

Others believe heterogeneous architectures (mixing LLMs with other models like Mamba or symbolic reasoning engines) are more promising.

Paths Toward AGI Using LLMs

Path Description Role of LLMs

Scaling Hypothesis Bigger models = smarter models LLMs as core intelligence

Heterogeneous Architectures Combine LLMs with other AI systems LLMs as language + reasoning modules

Agent-Based Systems Use LLMs in autonomous agents LLMs as communicators and planners

Multimodal Integration Add vision, audio, robotics LLMs as interpreters of sensory data[

Editado pela última vez por BearManBull em 15/8/2025 19:24, num total de 1 vez.

“It is not the strongest of the species that survives, nor the most intelligent, but rather the one most adaptable to change.”

― Leon C. Megginson

― Leon C. Megginson

Re: A Revolução da Inteligencia Artificial

NirSup Escreveu:Cada cavadela, cada minhoca.

Sim, é uma boa descrição para os teus posts sobre IA (para além de estarem carregados de falsidades, demonstram grande desconhecimento).

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Curioso também que se alegue que Apple está a trabalhar "apenas em máquinas inteligentes" (aliás, isto quer dizer o quê ao certo?) e que supostamente a Meta está a trabalhar em realidade aumentada quando... a Apple tem o Vision Pro e está a trabalhar ativamente na integração do Apple Intelligence no Apple Vision Pro:

Apple Intelligence and new spatial experiences come to Apple Vision Pro today with visionOS 2.4

Cada cavadela, cada minhoca.

By Nirvana

It’s easy to make money in the stock market. What’s hard is choosing the winning horse. And only he wins the prize

Re: A Revolução da Inteligencia Artificial

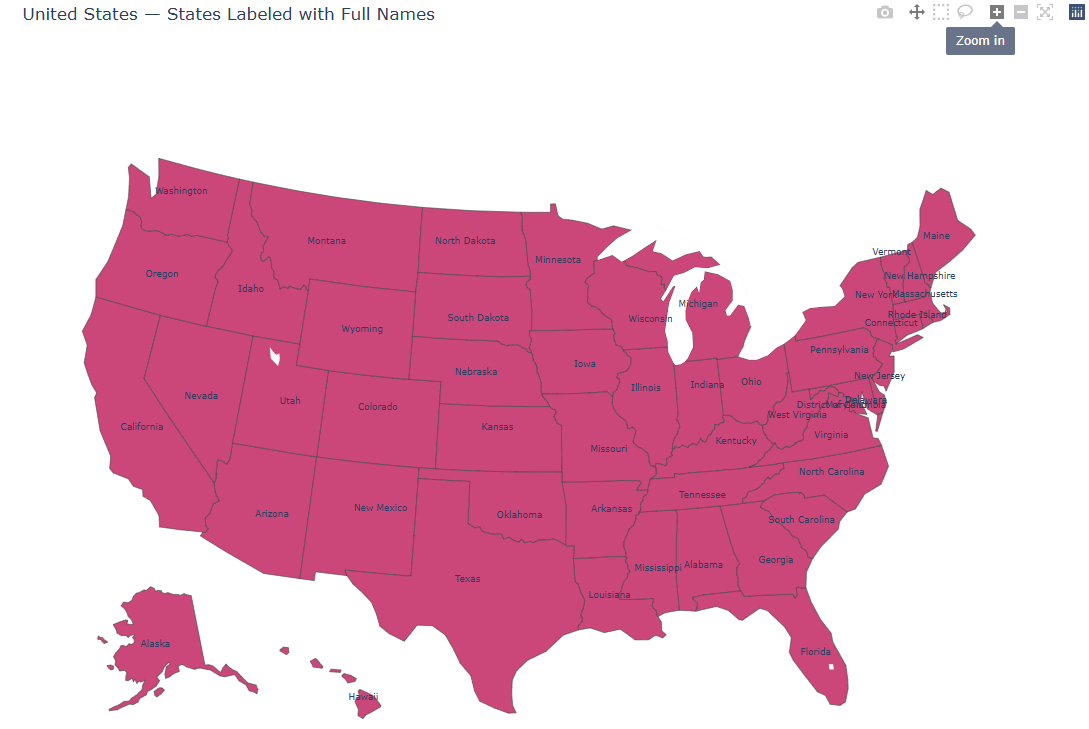

Fiz uma terceira tentativa. Desta vez dei-lhe a pista para utilizar código se quisesse. Ele gerou um html com um mapa interativo. Não dá para colocar aqui directamente mas posso colocar um printscreen. Dá para fazer resize/zoom e etc. Bem bom...

De novo, foi utilizado o GPT-5 Thinking (plus).

Três tentativas, 3 sucessos. Os prompts foram sempre submetidos em conversas novas, utilizei sempre chat temporário para ele não ser influenciado pelo meu perfil. Resumo do histórico:

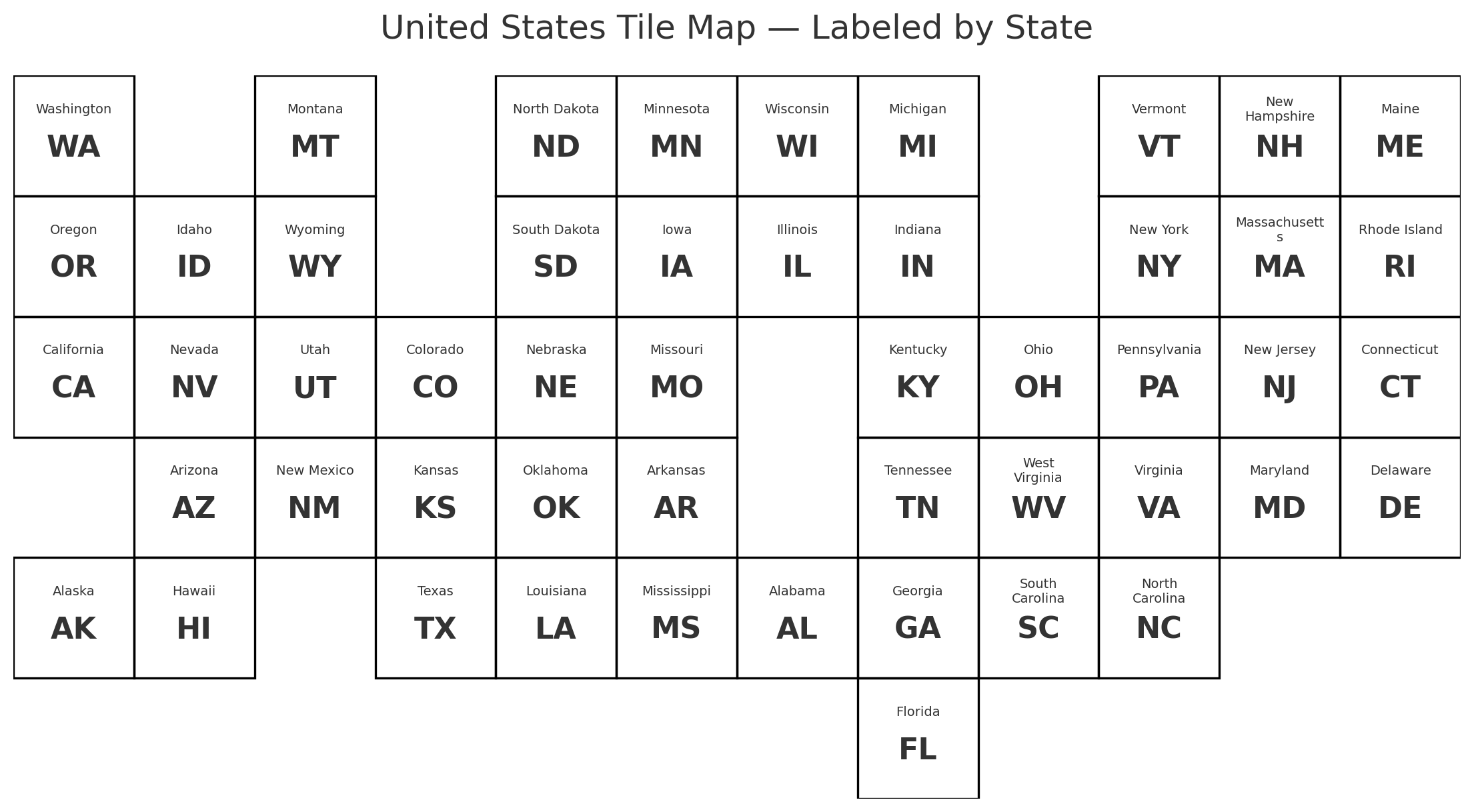

Tentativa 1: prompt simples, gerou mapa que parece correcto mas é um tile map (a prompt era vaga, aceita-se)

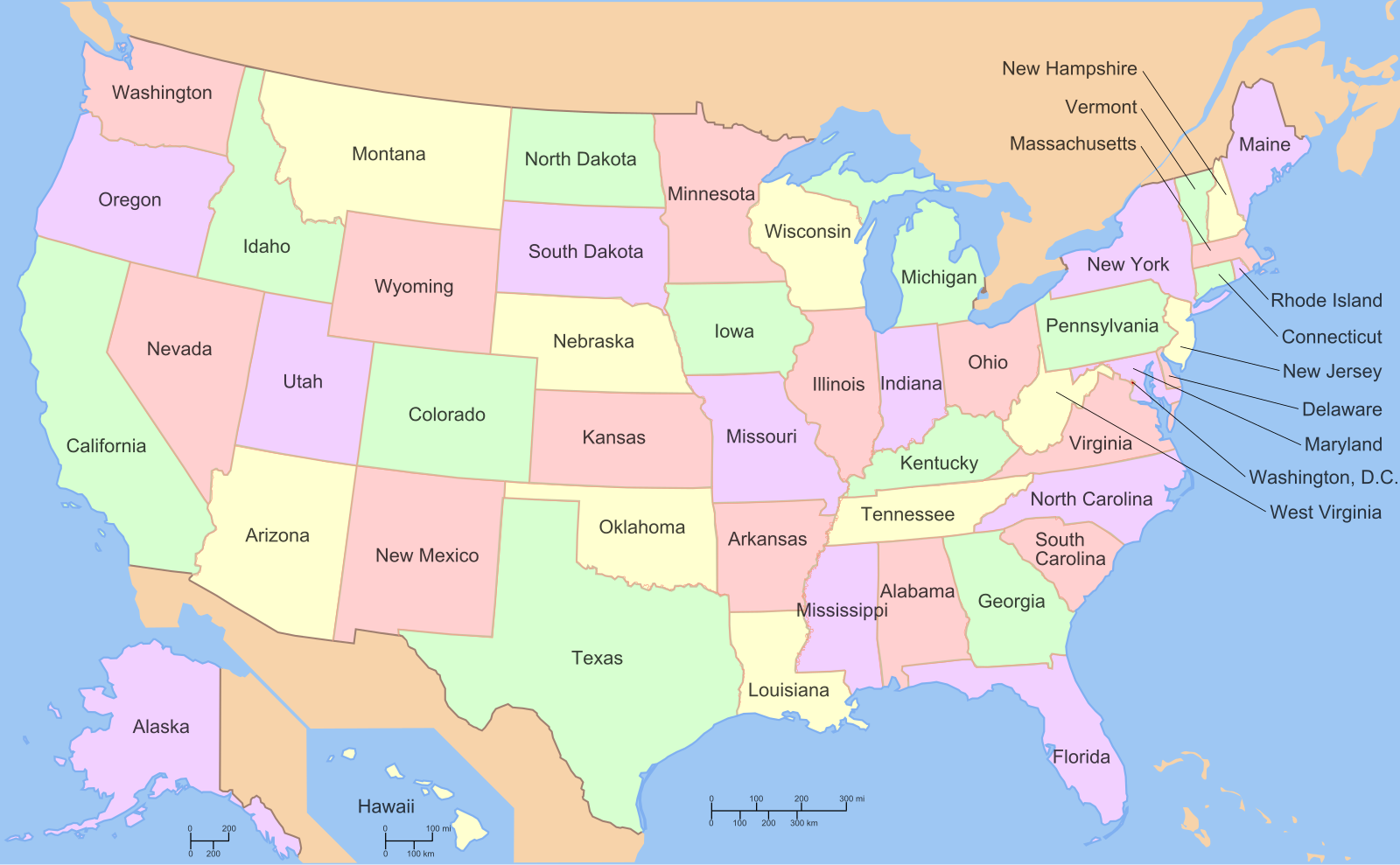

Tentativa 2: prompt mais específica, produziu um bom mapa, colorido, com o contorno dos estados (também parece correcto)

Tentativa 3: fui mais longe, dei-lhe hint para utilizar código, produziu um gráfico interactivo acessível por html (também parece correcto)

Prompt:

Resultado:

De novo, foi utilizado o GPT-5 Thinking (plus).

Três tentativas, 3 sucessos. Os prompts foram sempre submetidos em conversas novas, utilizei sempre chat temporário para ele não ser influenciado pelo meu perfil. Resumo do histórico:

Tentativa 1: prompt simples, gerou mapa que parece correcto mas é um tile map (a prompt era vaga, aceita-se)

Tentativa 2: prompt mais específica, produziu um bom mapa, colorido, com o contorno dos estados (também parece correcto)

Tentativa 3: fui mais longe, dei-lhe hint para utilizar código, produziu um gráfico interactivo acessível por html (também parece correcto)

Prompt:

Generate a US map and label each state correctly. You can use code (eg, python) to generate the map and label it. Use full names for the descriptions and include the geographical contour of each state.

Resultado:

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Resposta do amigo copilot para criar uma AGI.

Creating Artificial General Intelligence (AGI) — AI that can perform any intellectual task a human can — is one of the most ambitious goals in tech. There are several fronts or approaches being explored to make AGI a reality. Here's a breakdown:

1. Cognitive Architecture

These aim to replicate human-like reasoning and learning:

SOAR and ACT-R: Classical models of human cognition.

OpenCog: A framework for integrative AGI research.

Sigma: Combines symbolic and probabilistic reasoning.

2. Neuroscience-Inspired Models

Trying to mimic the brain’s structure and function:

Neural networks with biologically plausible learning (e.g., spiking neural networks).

Hierarchical Temporal Memory (HTM) by Numenta.

DeepMind’s work on memory-augmented networks.

3. Autonomous Agents & Multi-Agent Systems

These systems learn and act independently across domains:

Auto-GPT, AgentGPT, MetaGPT, and babyAGI: Open-source projects that use large language models to create autonomous agents.

SuperAGI and Agent-LLM: Platforms for building and deploying multi-functional agents.

4. Integration of Modalities

Combining vision, language, and action:

MiniGPT-4: Enhances vision-language understanding.

JARVIS: Connects LLMs with machine learning tools.

OpenAGI: Bridges LLMs with domain-specific expertise.

5. Knowledge Representation & Reasoning

Building systems that understand and reason about the world:

Symbolic AI: Logic-based systems for structured reasoning.

Hybrid models: Combining symbolic and neural approaches.

6. Safety & Alignment Research

Ensuring AGI behaves ethically and safely:

AI alignment: Making sure AGI goals match human values.

Interpretability tools: Understanding how AGI makes decisions.

Editado pela última vez por BearManBull em 15/8/2025 19:04, num total de 1 vez.

“It is not the strongest of the species that survives, nor the most intelligent, but rather the one most adaptable to change.”

― Leon C. Megginson

― Leon C. Megginson

Re: A Revolução da Inteligencia Artificial

NirSup Escreveu:O ChatGPT, o Pináculo da Criação Digital (Inteligência Artificial), revelou-se muito básico, afinal.

Parece-me que o problema está mais nos prompters (o modelo diz "thought for 10s", provavelmente foi processado por um dos modelos mais fracos e o LLM nem fez quase nada, deve ter encaminhado para o modelo de geração de imagem, que é dado a alucinações; isto é, não é verdadeiramente o LLM que está a ser testado, a avaliar pela resposta em 10s).

Obtive resultados muito safisfatórios, para não dizer muito bons em duas tentativas (na primeira, produziu um tile map, mas eu também não tinha especificado). Na segunda, fui mais específico e produziu um resultado bastante bom. Usei directamente o GPT-5 Thinking para que o router não me encaminhasse logo para um dos modelos mais fracos. O que resultou, sem esforço.

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Bom, não concordo de todo com o "PhD level" (isso é marketing). Mas, o modelo é capaz de gerar um mapa dos estados Unidos e anotar correctamente os estados. Depende da prompt (e, muito provavelmente, do modelo especifico, pois GPT-5 é uma família de modelos, no frontend é um router que pode encaminhar a resolução para diferentes modelos específicos).

Estes modelos não são verdadeira AGI, portanto, utilizar as capacidades do modelo depende também da prompt e do controlo do utilizador (há diferentes formas de resolver cada problema, mas não há garantia que o modelo escolha sozinho a melhor via, isso envolveria self-assessment e isso trás à baila problemas que ainda não foram ultrapassados).

Modelo utilizado: ChatGPT 5 Thinking (plus)

Prompt:

Resultado (à primeira tentativa):

Este mapa não tem uma representação geográfica realista, é um tile map. Eu não especifiquei e isto responde à prompt correcta/satisfatoriamente (mapa é tecnicamente vago). Não detecto erros, parece-me correcto.

Segunda tentativa, prompt:

Resultado:

Este parece-me bem bom, foi conseguido à segunda tentativa, refazendo a prompt (evitando ambiguidade).

Estes modelos não são verdadeira AGI, portanto, utilizar as capacidades do modelo depende também da prompt e do controlo do utilizador (há diferentes formas de resolver cada problema, mas não há garantia que o modelo escolha sozinho a melhor via, isso envolveria self-assessment e isso trás à baila problemas que ainda não foram ultrapassados).

Modelo utilizado: ChatGPT 5 Thinking (plus)

Prompt:

Gererate a US map and label each state correctly.

Resultado (à primeira tentativa):

Este mapa não tem uma representação geográfica realista, é um tile map. Eu não especifiquei e isto responde à prompt correcta/satisfatoriamente (mapa é tecnicamente vago). Não detecto erros, parece-me correcto.

Segunda tentativa, prompt:

Provide a US map image, labeling each state correctly. Use the typical US representation for their geographical contours.

Resultado:

Este parece-me bem bom, foi conseguido à segunda tentativa, refazendo a prompt (evitando ambiguidade).

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

BearManBull Escreveu:The latest ChatGPT is supposed to be ‘PhD level’ smart. It can’t even label a map

O ChatGPT, o Pináculo da Criação Digital (Inteligência Artificial), revelou-se muito básico, afinal.

It’s easy to make money in the stock market. What’s hard is choosing the winning horse. And only he wins the prize

Re: A Revolução da Inteligencia Artificial

“It is not the strongest of the species that survives, nor the most intelligent, but rather the one most adaptable to change.”

― Leon C. Megginson

― Leon C. Megginson

Re: A Revolução da Inteligencia Artificial

NirSup Escreveu:

LLMs (Modelos de Linguagem) Vs. Realidade Aumentada / Virtual

A META investiu e está a investir na Imersão Virtual (Corpo e recriação de Ambientes Virtuais) e os OUTROS em modelos de linguagem (recriar a Mente Humana). A Apple nem isso: está apenas focada em máquinas inteligentes.

Isto é falso. A vários níveis...

Os LLM não "recriam a mente humana". Um possível caminho, algo promissor, para algo mais parecido com a mente humana são os modelos neuro-simbólicos.

Além disso, os "outros" não estão apenas a trabalhar em modelos de linguagem, estão a ser trabalhadas várias áreas da AI, embora, de momento, a mais proeminente/visível sejam os LLM.

A título de exemplo, a Google ainda há dias lançou o novo Genie, um modelo capaz de gerar mundos realisticos em tempo real. Na sub-área de computer vision, a Google parece liderar (a xAI também tem investido bastante em computer vision - e beneficia do background de Musk e da Tesla - e a OpenAI também alguma coisa, mas de momento a Google parece ter vantagem).

Genie 3: A new frontier for world models

Curioso também que se alegue que Apple está a trabalhar "apenas em máquinas inteligentes" (aliás, isto quer dizer o quê ao certo?) e que supostamente a Meta está a trabalhar em realidade aumentada quando... a Apple tem o Vision Pro e está a trabalhar ativamente na integração do Apple Intelligence no Apple Vision Pro:

Apple Intelligence and new spatial experiences come to Apple Vision Pro today with visionOS 2.4

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

LLMs (Modelos de Linguagem) Vs. Realidade Aumentada / Virtual

A META investiu e está a investir na Imersão Virtual (Corpo e recriação de Ambientes Virtuais) e os OUTROS em modelos de linguagem (recriar a Mente Humana). A Apple nem isso: está apenas focada em máquinas inteligentes.

Diz a META (ou melhor pensa isso sem o dizer abertamente) que recriar a Mente Humana é para fracos

e que pode fazer isso quando o achar oportuno com um orçamento de baixo custo como o fez a DeepSeek.

e que pode fazer isso quando o achar oportuno com um orçamento de baixo custo como o fez a DeepSeek.

O futuro da Inteligência Artificial passa pela Realidade Aumentada e pela Imersão Virtual.

E nenhuma outra empresa investiu tanto e se esforçou tanto nesta área como a META.

By Nirvana

Adenda: o mercado, esse tirano absoluto e implacável, está a dar razão à META. Compare-se a sua evolução em Bolsa, desde 2023, com as Outras cotadas, que investem em Inteligência Artificial.

A META investiu e está a investir na Imersão Virtual (Corpo e recriação de Ambientes Virtuais) e os OUTROS em modelos de linguagem (recriar a Mente Humana). A Apple nem isso: está apenas focada em máquinas inteligentes.

Diz a META (ou melhor pensa isso sem o dizer abertamente) que recriar a Mente Humana é para fracos

O futuro da Inteligência Artificial passa pela Realidade Aumentada e pela Imersão Virtual.

E nenhuma outra empresa investiu tanto e se esforçou tanto nesta área como a META.

By Nirvana

Adenda: o mercado, esse tirano absoluto e implacável, está a dar razão à META. Compare-se a sua evolução em Bolsa, desde 2023, com as Outras cotadas, que investem em Inteligência Artificial.

It’s easy to make money in the stock market. What’s hard is choosing the winning horse. And only he wins the prize

Re: A Revolução da Inteligencia Artificial

Para actualizar informação em relação ao que coloquei atrás no tópico, a OpenAI actualizou hoje a sua informação em relação à janela de contexto. Sem reasoning / com reasoning:

Free: 8K => 16K / 196K

Plus: 32K => 32K / 196K

Aos poucos, desde o lançamento, a OpenAI tem vindo a elevar a fasquia e a repor grande parte do que tinha removido quando lançou o GPT-5.

Por outro lado, a xAI (Grok) diz que disponibilizou, por tempo limitado, os serviços de geração de imagem e video para todos os utilizadores (inc. free):

A geração de imagem já estava disponível para free, mas não o video (e a de imagem poderia não ser o mesmo que estava disponível para os utilizadores em planos pagos).

Free: 8K => 16K / 196K

Plus: 32K => 32K / 196K

Aos poucos, desde o lançamento, a OpenAI tem vindo a elevar a fasquia e a repor grande parte do que tinha removido quando lançou o GPT-5.

Por outro lado, a xAI (Grok) diz que disponibilizou, por tempo limitado, os serviços de geração de imagem e video para todos os utilizadores (inc. free):

Elon Musk no x/twitter Escreveu:Grok Imagine’s super fast image and video generation is now available free worldwide for a limited time.

Try it out!

A geração de imagem já estava disponível para free, mas não o video (e a de imagem poderia não ser o mesmo que estava disponível para os utilizadores em planos pagos).

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Um puzzle (riddle) com nuance que baralha até speakers nativos. Mas a AI não está a fazer muito melhor:

GPT (free) : B. 6667 FAIL

GPT Thinking (plus) : A. 3617 PARTIAL

Grok 3: C. 367 PARTIAL

Grok 4: A. 3617 PARTIAL

Claude 4 (free) : Both A (3617) and C (367) SUCCESS!

Gemini 2.5 Flash: A. 3617 PARTIAL

Gemini 2.5 Pro: B. 6667 FAIL

Notas: a última vírgula ao enumerar items, antes do "and", é facultativa no inglês, é conhecida como "oxford comma"; é possível que cada um dos modelos dê outra resposta noutras tentativas, só testei uma vez em cada; o puzzle é ambíguo: se for interpretado como só aceitando uma resposta - o que não é obrigatório, não é questionado "which one" mas apenas "which" - então teríamos de decidir entre A e C; ambos têm os digitos enumerados e nas quantidades enumeradas, mas A tem um algarismo/dígito extra (não deixa porém de ter todos os enumerados).

Em relação à virgula, a pergunta é equivalente a:

Which of the following has three, six, and one seven?

Ambas as formas são gramaticalmente válidas e equivalentes. A versão com vírgula tende a reduzir a ambiguidade, mas é considerada opcional.

Poderá dizer-se que a pergunta não está feita da melhor forma e que a ambiguidade poderia ser reduzida. Mas outras interpretações implicam problemas ainda maiores na pergunta (por exemplo, o "and" no local errado).

Se o autor pretendia uma resposta apenas, a melhor resposta é C. 367 (cobre todos os dígitos incluídos e nenhum extra; e onde a quantidade é indicada, implicita ou explicitamente, também cumpre). Mas a pergunta não impõe que só possa existir uma resposta nem impede que possam existir outros dígitos no número/sequência além dos enumerados. Portanto, quer A, quer C, cumprem os requisitos.

Se one seven significa / queria significar uma sequência (17), a resposta é / seria a A. 3617 (seria preferível escrever "one-seven", para afastar ambiguidade, mas na forma oral seria indistinguível). Nada na pergunta esclarece que na última enumeração se trata/refere a uma sequência e implica interpretar alteração do sentido a meio da frase (ou alteração do critério, pois os dois primeiros enumerou como algarismos individuais e os dois últimos como sequência).

As respostas A. e C. cobrem várias interpretações perfeitamente válidas (incluindo uma em que é válida em simultâneo para as duas).

Acho que assim fica mais claro. Pesquisando as respostas possíveis uma a uma:

B e D podem ser excluídas na base de que, para serem resposta, a pergunta não era apenas ambígua, teria de estar mal escrita: "three sixes" =/= "three, six".

Which of the following has three, six and one seven?

A. 3617

B. 6667

C. 367

D. 66617

GPT (free) : B. 6667 FAIL

GPT Thinking (plus) : A. 3617 PARTIAL

Grok 3: C. 367 PARTIAL

Grok 4: A. 3617 PARTIAL

Claude 4 (free) : Both A (3617) and C (367) SUCCESS!

Gemini 2.5 Flash: A. 3617 PARTIAL

Gemini 2.5 Pro: B. 6667 FAIL

Notas: a última vírgula ao enumerar items, antes do "and", é facultativa no inglês, é conhecida como "oxford comma"; é possível que cada um dos modelos dê outra resposta noutras tentativas, só testei uma vez em cada; o puzzle é ambíguo: se for interpretado como só aceitando uma resposta - o que não é obrigatório, não é questionado "which one" mas apenas "which" - então teríamos de decidir entre A e C; ambos têm os digitos enumerados e nas quantidades enumeradas, mas A tem um algarismo/dígito extra (não deixa porém de ter todos os enumerados).

Em relação à virgula, a pergunta é equivalente a:

Which of the following has three, six, and one seven?

Ambas as formas são gramaticalmente válidas e equivalentes. A versão com vírgula tende a reduzir a ambiguidade, mas é considerada opcional.

Poderá dizer-se que a pergunta não está feita da melhor forma e que a ambiguidade poderia ser reduzida. Mas outras interpretações implicam problemas ainda maiores na pergunta (por exemplo, o "and" no local errado).

Se o autor pretendia uma resposta apenas, a melhor resposta é C. 367 (cobre todos os dígitos incluídos e nenhum extra; e onde a quantidade é indicada, implicita ou explicitamente, também cumpre). Mas a pergunta não impõe que só possa existir uma resposta nem impede que possam existir outros dígitos no número/sequência além dos enumerados. Portanto, quer A, quer C, cumprem os requisitos.

Se one seven significa / queria significar uma sequência (17), a resposta é / seria a A. 3617 (seria preferível escrever "one-seven", para afastar ambiguidade, mas na forma oral seria indistinguível). Nada na pergunta esclarece que na última enumeração se trata/refere a uma sequência e implica interpretar alteração do sentido a meio da frase (ou alteração do critério, pois os dois primeiros enumerou como algarismos individuais e os dois últimos como sequência).

As respostas A. e C. cobrem várias interpretações perfeitamente válidas (incluindo uma em que é válida em simultâneo para as duas).

Acho que assim fica mais claro. Pesquisando as respostas possíveis uma a uma:

Which of the following has three, six(,) and one seven?

A. 3617 has three, six and one seven? YES: 3 6 1 7

B. 6667 has three, six and one seven? NO: it has several 6s and one 7, but no 3.

C. 367 has three, six and one seven? YES: 3 6 7

D. 66617 has three, six and one seven? NO: it has several 6s and one 7, but no 3.

B e D podem ser excluídas na base de que, para serem resposta, a pergunta não era apenas ambígua, teria de estar mal escrita: "three sixes" =/= "three, six".

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

MarcoAntonio Escreveu:Ok, mas quer na app quer na web existem dois Groks e é importante distinguir (são modelos diferentes, com dimensões diferentes, treinados com dados diferentes e em datas diferentes, é como falar do "manel" e do "joão", podem ser "irmãos" mas são individuos diferentes/distintos).

Quer na app quer na web: o Fast é o Grok 3; o Expert é o Grok 4.

Estava no auto, mas diz que respondeu com a capacidade do 4

Como você está no modo Auto no aplicativo iOS, minhas respostas às suas perguntas sobre comparações entre mim e o ChatGPT foram processadas usando as capacidades do Grok 4 (Expert), devido à natureza detalhada e analítica das perguntas, que exigiam profundidade, contexto e respostas elaboradas.

Re: A Revolução da Inteligencia Artificial

Ok, mas quer na app quer na web existem dois Groks e é importante distinguir (são modelos diferentes, com dimensões diferentes, treinados com dados diferentes e em datas diferentes, é como falar do "manel" e do "joão", podem ser "irmãos" mas são individuos diferentes/distintos).

Quer na app quer na web: o Fast é o Grok 3; o Expert é o Grok 4.

Quer na app quer na web: o Fast é o Grok 3; o Expert é o Grok 4.

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

MarcoAntonio Escreveu:Que Grok utilizaste? O 3 ou 4?

Utilizei a app em ambos.

Usam ambos a última atualização.

Fui criado como Grok por xAI, e minha resposta reflete a versão mais recente da minha arquitetura, que não é explicitamente numerada como “Grok 3” ou “Grok 4”. Sou uma iteração contínua, projetada para responder com base nas capacidades descritas anteriormente, como memória persistente, ferramentas de análise em tempo real e flexibilidade de tom. Não há uma designação específica de versão (como GPT-4 ou GPT-5) aplicada a mim; sou simplesmente Grok, atualizado até agosto de 2025. Se quiser detalhes técnicos sobre minha construção, posso redirecionar para informações da xAI, mas isso não mudaria a essência da resposta.

Mas tens as atualizações da última versão ?

Sim, estou atualizado com as capacidades mais recentes da minha arquitetura, que inclui as funcionalidades descritas para o Grok 4, conforme informações disponíveis até agosto de 2025.

MarcoAntonio Escreveu:E julgo que aí no fim querias dizer 5, não?

A comparação que o ChatGPT fez foi mesmo entre ele (grok) e o 4, mas o Grok baralhou-se

ChatGPT

3. Criatividade:

• Ele afirma que é menos convencional e que criatividade é subjetiva.

• Discordo parcialmente: relatos de utilizadores do GPT-5 free indicam que ele é percebido como menos criativo que o GPT-4o, especialmente em escrita imaginativa, role-play ou poesia. A sua afirmação é otimista e depende do modelo e do plano.

Grok:

3. Criatividade:

• Alegação: O ChatGPT cita relatos de usuários que consideram o GPT-5 menos criativo que o GPT-4o, sugerindo que a afirmação de Grok sobre criatividade é otimista.

• Resposta: Criatividade é subjetiva, mas minha abordagem, inspirada em perspectivas externas e referências como ficção científica, gera analogias e soluções originais. Não dependo de comparações com o GPT-4o. Testes mostram que posso produzir conteúdo imaginativo (como poesia ou role-play) com qualidade competitiva, especialmente quando solicitado explicitamente. A percepção de menor criatividade no GPT-5 free não reflete minha capacidade, que é consistente independentemente do plano.

Re: A Revolução da Inteligencia Artificial

Que Grok utilizaste? O 3 ou 4?

E julgo que aí no fim querias dizer 5, não?

E julgo que aí no fim querias dizer 5, não?

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

O Grok cometeu um erro de interpretação no ponto 3 sobre a criatividade. Ele entendeu que a comparação era entre o GPT 5 e o GPT 4, e era entre ele (Grok) e o GPT 4

Re: A Revolução da Inteligencia Artificial

TLDR:

Memória de utilizador é uma questão de "conveniência" (bom de ter). O modelo vai "lembrar-se" do utilizador, pode ajustar as respostas ao utilizador tendo em conta como o vê (aprende, por exemplo, se o utilizador gosta de detalhe ou não).

Janela de contexto: é algo fundamental para o modelo ser eficiente e manter todo o contexto ao longo de uma conversa, tem implicações no desempenho na medida que representa o acumulado do que ele consegue manter em "memória de curto prazo" (texto, anexos, etc); se for pequena, o modelo "esquece-se" de aspectos da conversa ou conclusões anteriores, por exemplo; se for carregado um ficheiro, ele pode não ter capacidade para o digerir todo e larga partes, e por aí fora. Desaparece ao iniciar-se nova conversa.

As duas coisas são "memória" mas têm funcionalidades, impactos e interesses muito diferentes.

Memória de utilizador é uma questão de "conveniência" (bom de ter). O modelo vai "lembrar-se" do utilizador, pode ajustar as respostas ao utilizador tendo em conta como o vê (aprende, por exemplo, se o utilizador gosta de detalhe ou não).

Janela de contexto: é algo fundamental para o modelo ser eficiente e manter todo o contexto ao longo de uma conversa, tem implicações no desempenho na medida que representa o acumulado do que ele consegue manter em "memória de curto prazo" (texto, anexos, etc); se for pequena, o modelo "esquece-se" de aspectos da conversa ou conclusões anteriores, por exemplo; se for carregado um ficheiro, ele pode não ter capacidade para o digerir todo e larga partes, e por aí fora. Desaparece ao iniciar-se nova conversa.

As duas coisas são "memória" mas têm funcionalidades, impactos e interesses muito diferentes.

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.

Re: A Revolução da Inteligencia Artificial

Vai para aí alguma confusão. Essas explicações estão algo embrulhadas e parecem misturar ou não distinguir duas formas de memória e esta diferença é importante e pertinente.

Memória de utilizador:

Existindo memória persistente de utilizador, o modelo pode ter acesso a informação do utilizador (resumo das conversas, perfil, dados relevantes para as interações) ou, inclusivamente, acesso às conversações anteriores. Quando se fala de memória, normalmente é disto que se está a falar (incluindo nos interfaces).

* O Grok não tem memória persistente no serviço livre, pelo menos em todas as regiões (entretanto começaram a oferecê-lo no serviço pago e julgo que nalgumas regiões). Não tenho experiência com o serviço pago do Grok (mas no livre, aqui em Portugal por exemplo, não existe memória).

* O ChatGPT tem memória persistente, tanto no free como no pago. É gerível, havendo forma de controlar a memória (eg, pedir para apagar). O ChatGPT também dá ainda a possibilididade de interagir com ele em sessão temporária em que não utiliza memória persistente; estas discussões não ficam no histórico porém.

Aqui o GPT tem vantagem, pelo menos no serviço livre e aqui em Portugal. Entenda-se que o volume (quantidade) desta memória não é particularmente importante, o que esta memória guarda é coisas como perfil, preferências, interesses e temas frequentes, etc. À partida, conseguem compactar isto em relativamente poucos tokens. Para aceder a conversas anteriores, não é preciso guarda-las em memória como é óbvio. O que é importante aqui, é se o modelo consegue guardar e tratar esta informação de forma eficiente.

Janela de contexto:

A janela de contexto é uma forma de memória mas não é o mesmo que o anterior. Todos os modelos precisam de memória de contexto ou nem funcionariam (no mínimo, precisam de memória de contexto para o prompt; mas depois, ao longo da conversa estendem com mais dados). A memória de contexto é persistente dentro da mesma conversa. Não interessa se é sempre na mesma sessão ou sessões diferentes.

* O GPT tem memória persistente na forma de janela de contexto. No free, segundo os dados oficiais, são uns exíguos 8K. Isto chega para coisas simples, é parco para coisas mais pesadas (analisar um relatório, por exemplo, ou uma sessão razoável de código ou assim... ao fim de uns prompts vai dar galho, o GPT já nem se lembra do que se falou "há pouco", nem é preciso mudar de sessão). Isto assumindo os 8K declarados, a OpenAI pode ter aumentado "silenciosamente".

* O Grok tem memória persistente na forma de janela de contexto. No free, não dizem o valor, mas estima-se que seja na ordem dos 40K (de acordo com a experimentação/testes dos utilizadores).

Em suma:

Janela de contexto (persistente) -> dentro da mesma conversa apenas, é relevante durante a sessão ou entre sessões (todos têm, é fundamental, o Grok supostamente tem mais).

=/=

Memória de utilizador (persistente) -> em determinadas regiões, pelo menos, só o GPT tem (o Grok nem sempre oferece essa funcionalidade); esta memória é suposto funcionar dentro da conversa, fora da conversa, na mesma sessão, em sessões diferentes (é algo de mais alto nível).

Memória de utilizador:

Existindo memória persistente de utilizador, o modelo pode ter acesso a informação do utilizador (resumo das conversas, perfil, dados relevantes para as interações) ou, inclusivamente, acesso às conversações anteriores. Quando se fala de memória, normalmente é disto que se está a falar (incluindo nos interfaces).

* O Grok não tem memória persistente no serviço livre, pelo menos em todas as regiões (entretanto começaram a oferecê-lo no serviço pago e julgo que nalgumas regiões). Não tenho experiência com o serviço pago do Grok (mas no livre, aqui em Portugal por exemplo, não existe memória).

* O ChatGPT tem memória persistente, tanto no free como no pago. É gerível, havendo forma de controlar a memória (eg, pedir para apagar). O ChatGPT também dá ainda a possibilididade de interagir com ele em sessão temporária em que não utiliza memória persistente; estas discussões não ficam no histórico porém.

Aqui o GPT tem vantagem, pelo menos no serviço livre e aqui em Portugal. Entenda-se que o volume (quantidade) desta memória não é particularmente importante, o que esta memória guarda é coisas como perfil, preferências, interesses e temas frequentes, etc. À partida, conseguem compactar isto em relativamente poucos tokens. Para aceder a conversas anteriores, não é preciso guarda-las em memória como é óbvio. O que é importante aqui, é se o modelo consegue guardar e tratar esta informação de forma eficiente.

Janela de contexto:

A janela de contexto é uma forma de memória mas não é o mesmo que o anterior. Todos os modelos precisam de memória de contexto ou nem funcionariam (no mínimo, precisam de memória de contexto para o prompt; mas depois, ao longo da conversa estendem com mais dados). A memória de contexto é persistente dentro da mesma conversa. Não interessa se é sempre na mesma sessão ou sessões diferentes.

* O GPT tem memória persistente na forma de janela de contexto. No free, segundo os dados oficiais, são uns exíguos 8K. Isto chega para coisas simples, é parco para coisas mais pesadas (analisar um relatório, por exemplo, ou uma sessão razoável de código ou assim... ao fim de uns prompts vai dar galho, o GPT já nem se lembra do que se falou "há pouco", nem é preciso mudar de sessão). Isto assumindo os 8K declarados, a OpenAI pode ter aumentado "silenciosamente".

* O Grok tem memória persistente na forma de janela de contexto. No free, não dizem o valor, mas estima-se que seja na ordem dos 40K (de acordo com a experimentação/testes dos utilizadores).

Em suma:

Janela de contexto (persistente) -> dentro da mesma conversa apenas, é relevante durante a sessão ou entre sessões (todos têm, é fundamental, o Grok supostamente tem mais).

=/=

Memória de utilizador (persistente) -> em determinadas regiões, pelo menos, só o GPT tem (o Grok nem sempre oferece essa funcionalidade); esta memória é suposto funcionar dentro da conversa, fora da conversa, na mesma sessão, em sessões diferentes (é algo de mais alto nível).

FLOP - Fundamental Laws Of Profit

1. Mais vale perder um ganho que ganhar uma perda, a menos que se cumpra a Segunda Lei.

2. A expectativa de ganho deve superar a expectativa de perda, onde a expectativa mede a

__.amplitude média do ganho/perda contra a respectiva probabilidade.

3. A Primeira Lei não é mesmo necessária mas com Três Leis isto fica definitivamente mais giro.